NikonもZ f でついにピクセルシフトを搭載したわけですが、搭載が遅かったのは、メーカーポリシーとしてそれって必要?というのがあったのかなと勝手に想像しています。

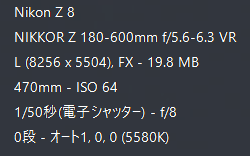

Z fは2,450万画素ですが、Z 8は4,571万画素と画素数も多く、ローパスフィルタレスのため、Z fとはまた違った感じになるのでしょうか?NX Studio で合成でのみ対応しています。

※Adobe CameraRAWとLightroom Classicはアップデートにより、NX Studioで生成されたRAWファイル(.NEFX)に対応しました

他メーカーのようにボディ内生成出来ないのは残念ですが、まだNikon的には実験的搭載なんでしょうかね?

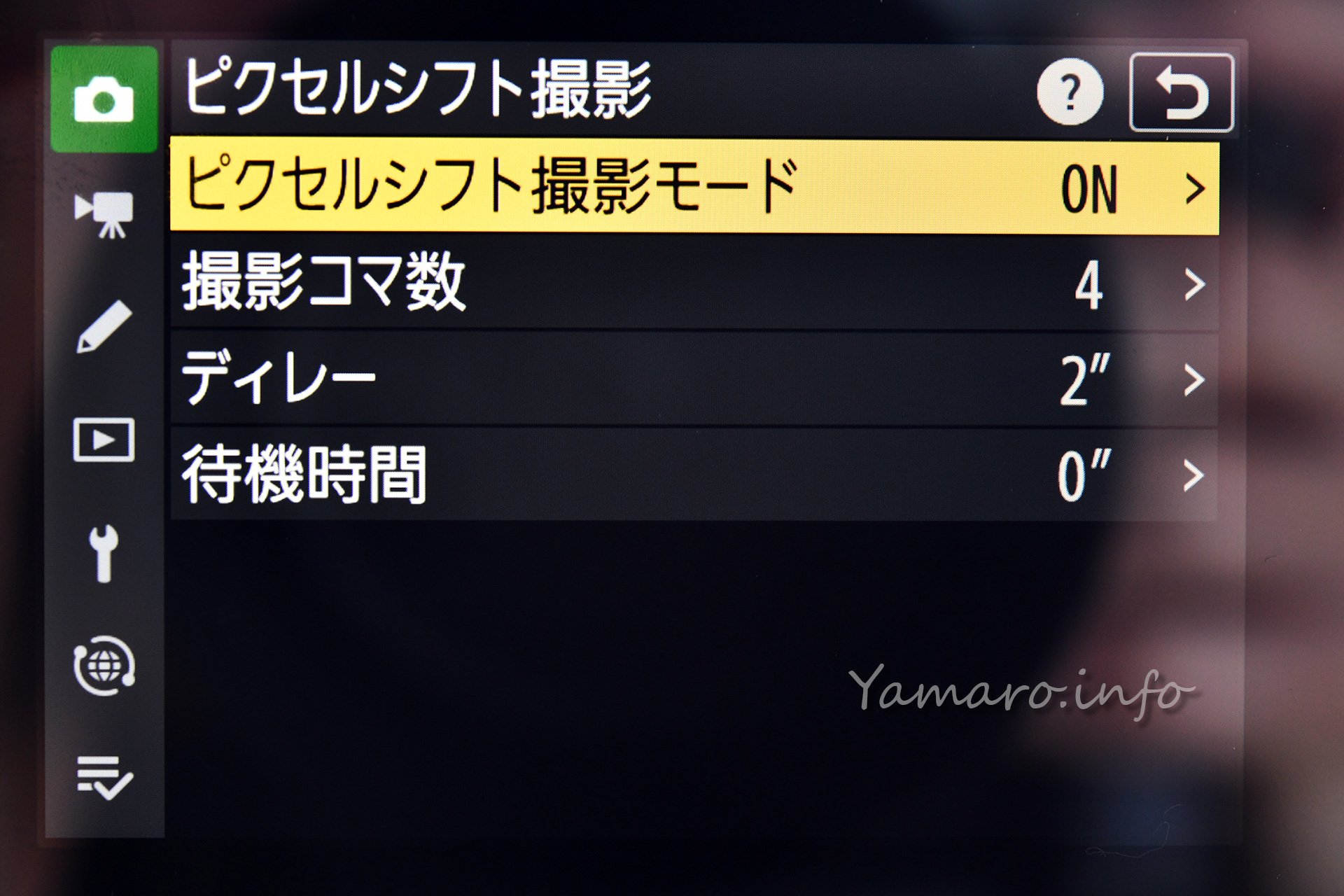

ピクセルシフト撮影で撮影する

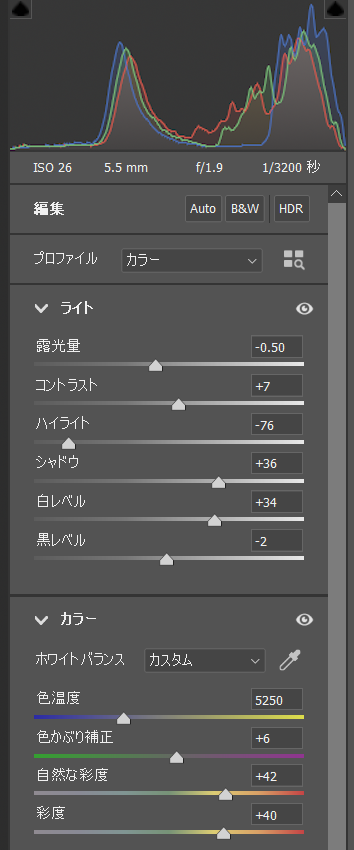

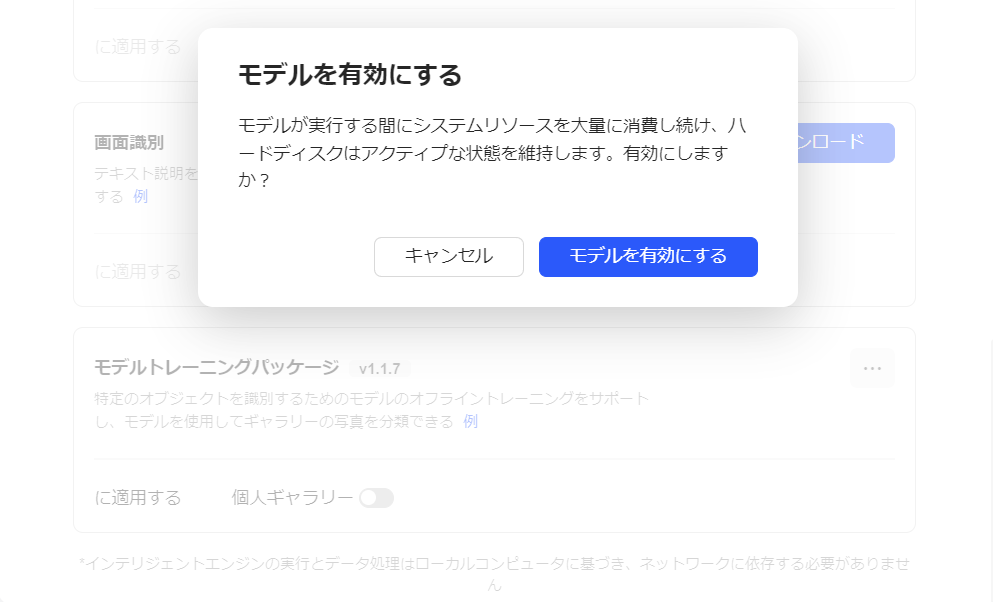

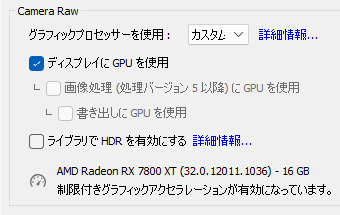

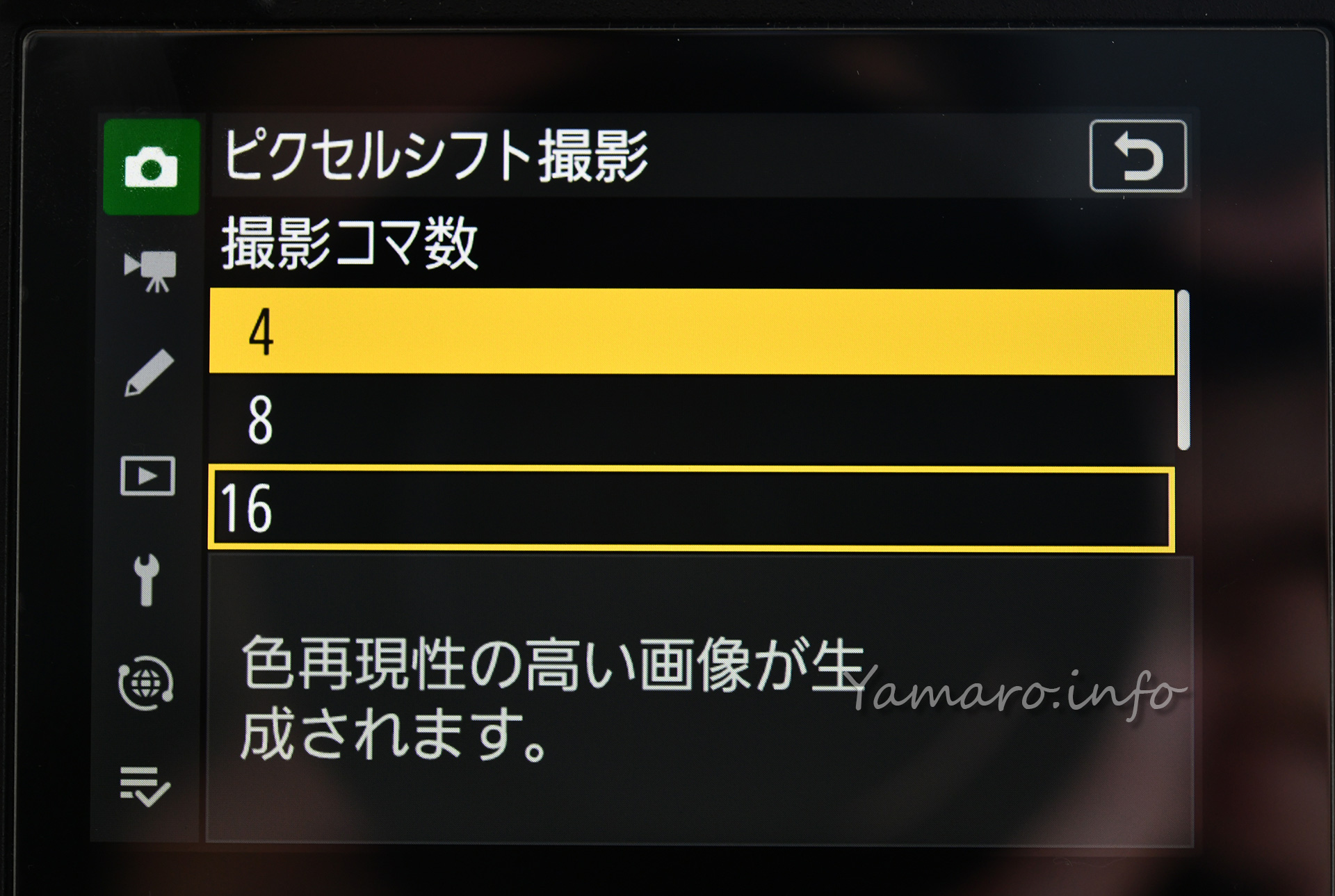

まずは静止画撮影メニューからピクセルシフトを設定します。

4コマ:色再現性の高い画像が生成されます。

8コマ:ノイズが軽減された色再現性の高い画像が生成されます。

16コマ:色再現性が高く高解像度の画像が生成されます。

32コマ:ノイズが軽減された色再現性が高く高解像度の画像が生成されます。

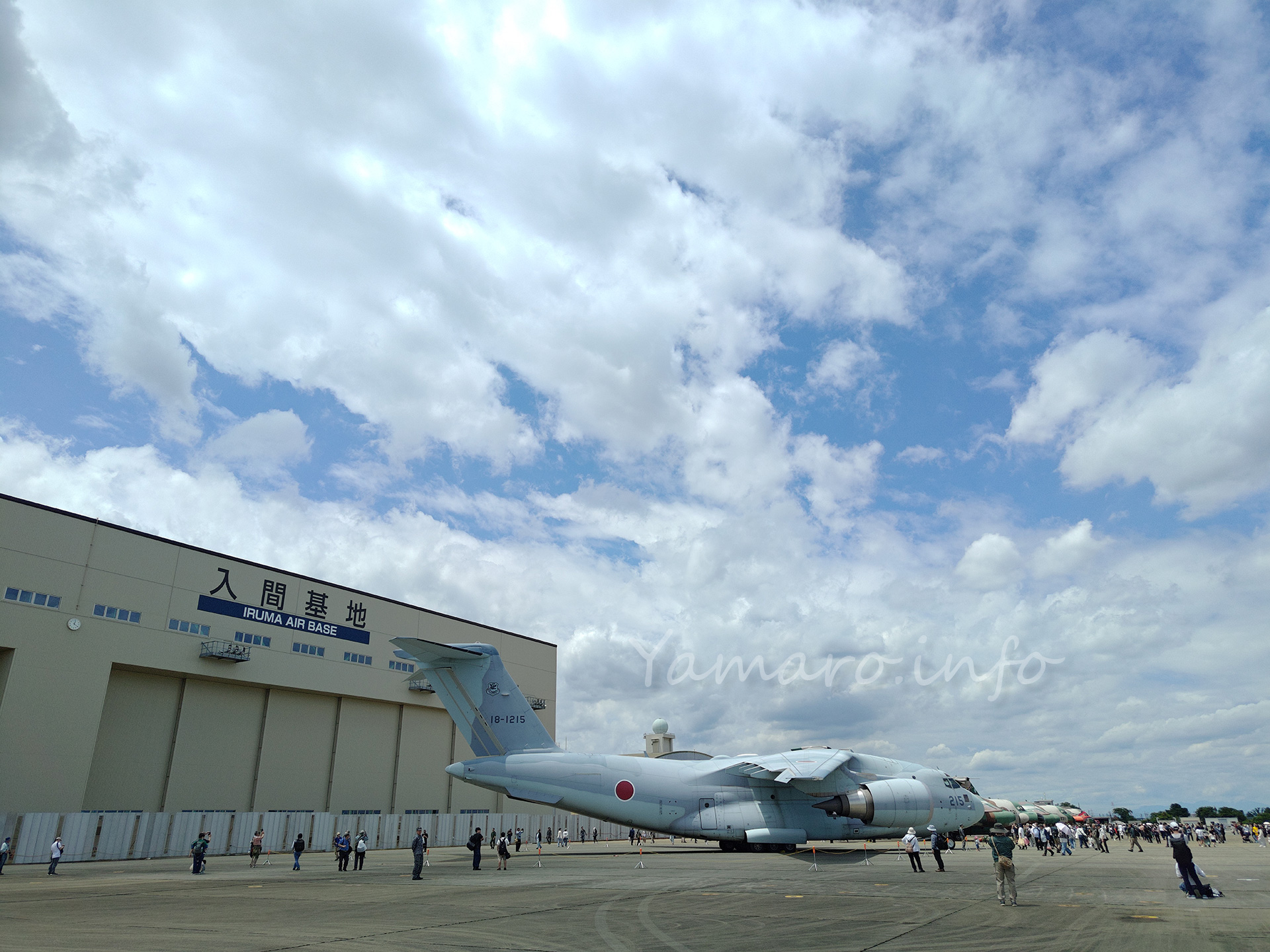

ピクセルシフト撮影の設定項目

ディレーはシャッターボタンを押して何秒後にピクセルシフト撮影が開始されるか(三脚撮影時のブレ防止)、待機時間は1コマ撮影毎の待機時間で、通常は0で連写で問題ないでしょう。

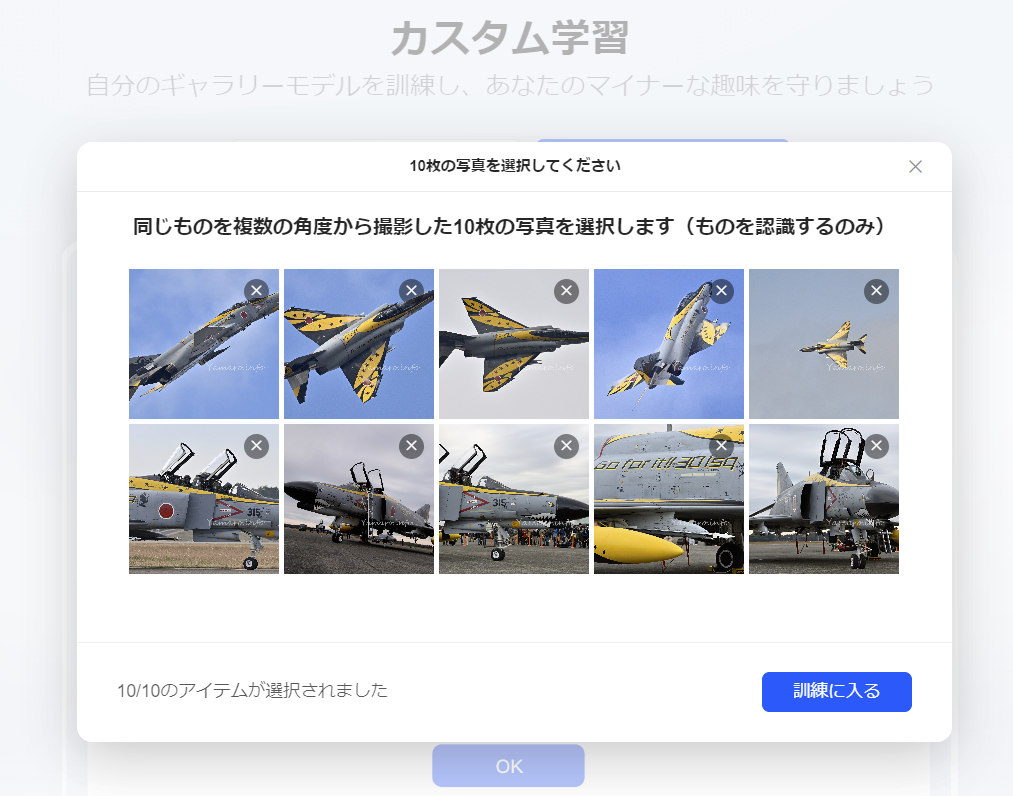

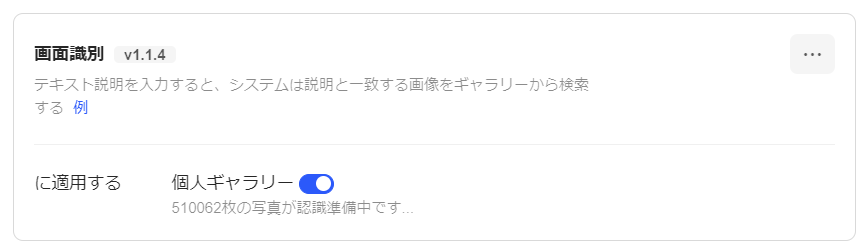

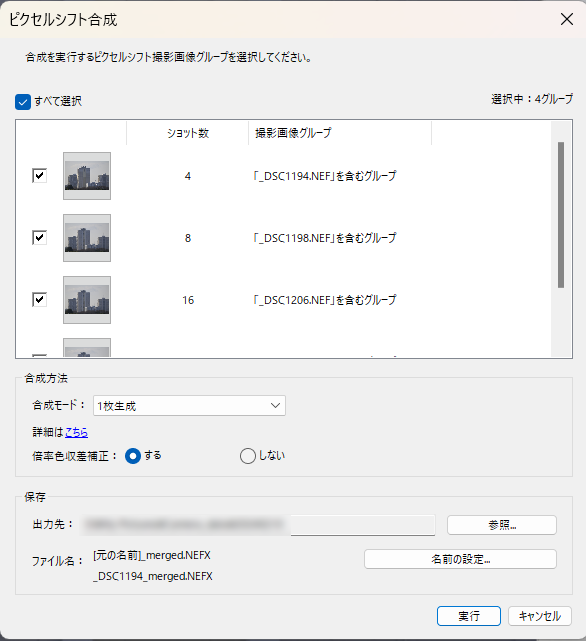

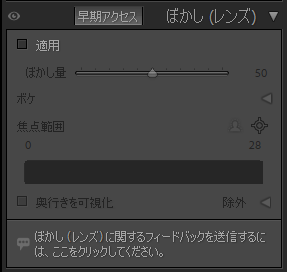

NX Studioで合成する

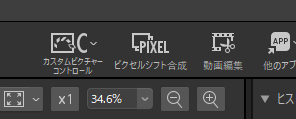

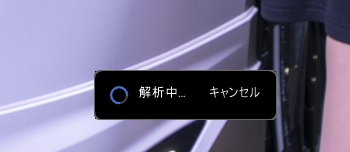

撮影した写真データをパソコンに取り込んで、NX Studioを起動します。

ピクセルシフトした画像の有るフォルダを参照し、左上にピクセルシフト合成があるので、クリックします。

すると、ピクセルシフト合成されたRAWファイル(拡張子は.NEFXになる)が生成されます。

一筋縄ではいかないピクセルシフト撮影

さて複数枚撮影して合成するピクセルシフト撮影ですが、生成されるファイルサイズも大きくなります。

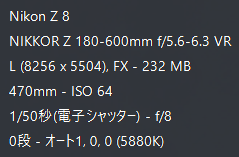

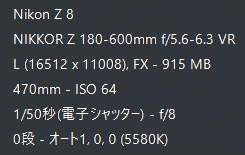

オリジナルファイルの高効率RAWは19.8MB 4枚合成と8枚合成では232MBのファイル生成 16枚と32枚では915MBのファイル生成、解像度も縦横2倍に

普段は最もファイルサイズが小さくなるRAWの高効率を使用しています。高効率★と比較して、やや暗部の階調で劣る部分があるようですが、厳密に比較しないとわからない程度なので、普段はほぼ高効率です。

今回RAWの設定は高効率のままでしたが、生成されるファイルは単純に高効率の4倍とはならず、ロスレス圧縮(1枚概ね45~49MB程度)の5倍程度(4,8枚合成の場合)の232MB か、あるいは19倍(16,32枚合成の場合)の915MB とかなり大きくなります。いずれも4倍、16倍とならないのが不思議です。

1枚が1GBに近いファイル は何とも扱いが大変ですね。

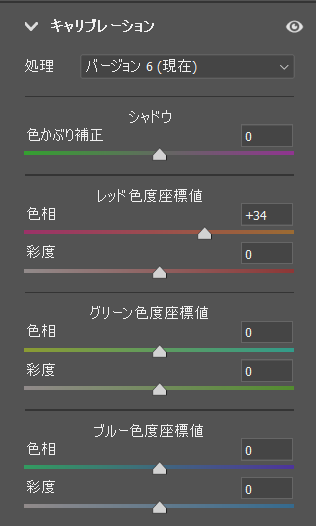

さて撮影結果。まずオリジナルファイルはこんな感じです。ブロクの制約で、オリジナル解像度のまま掲載できないため、解像度を絞っています。

オリジナル画像をWeb用に縮小(フルHD解像度)

このため、ドットバイドットの確認をできるよう、画像を切り抜きました。

オリジナル画像の切り抜き

4枚合成

4枚合成では「色再現性の高い画像が生成されます」とのこと。このモードでは解像度はオリジナルのままで、ベイヤーセンサの4ドット分を合成しているので、結果的にRGBを1つのピクセルで生成できることになります。通常ベイヤーセンサでは、周辺の色から画像を生成するため、単純にセンサのドット数通りの解像感や色再現が出ないとされていますが、それをピクセルシフトで合成させることで、色再現性を高めることになります。

4枚合成切り抜き

うーん、良くなったかどうかわからない…

←オリジナル 4枚合成→ あれ、解像感はオリジナルのほうがあるような…。ただ、4枚合成のほうが無理にシャープネスをかけていなく自然に感じます。4枚合成する以上、ごく僅かなブレも影響してきます。当然三脚は使っていますが、かなりシビアかもしれません。

8枚合成

「ノイズが軽減された色再現性の高い画像が生成されます」とあるように、4枚合成を2回行うことでノイズ軽減を図っているのでしょう。生成されるファイルは8枚合成でも1枚撮影と同じ解像度と4枚合成と同じファイルサイズです。

8枚合成、ボヤけてしまった…

残念ながらブレた可能性が高いです。画像が明らかにボヤけてしまっています。これは何回か撮影して良いものを採用するのが無難です。

←オリジナル 8枚合成→ ピクセルシフトの恩恵より歩留まりの悪さのほうが目立つ結果になりましたね。悪い例です。

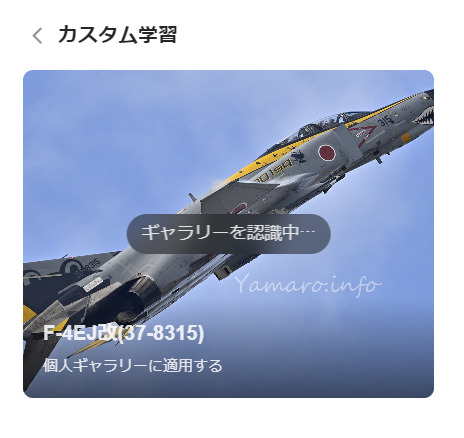

16枚合成

「色再現性が高く高解像度の画像が生成されます」とあるように、この16枚からは縦横共に解像度がオリジナルの2倍になります。シフト量を4,8枚の倍とすることで、解像度も上げるモードです。

16枚合成(4,8枚合成と同じ切り出しに)

16枚合成を横方向2000ピクセルで切り出し

やはりブレの影響か、冬とはいえ望遠なので空気のゆらぎ(陽炎)の影響もあると思われます。とにかくシャキッとしない画像になってしまいました。

←オリジナル 16枚合成→ 完全にブレと陽炎の影響ですね。ピクセルシフトは望遠撮影には不向きかもしれませんね。16枚撮影ともなると、秒20コマのZ 8でも1秒近く撮影を行うので、三脚とはいえ微ブレと陽炎の影響は無視できないでしょう。

32枚合成

「ノイズが軽減された色再現性が高く高解像度の画像が生成されます。」ということで、16枚合成を更にもう1回行うということでしょう。画像データも相当なものになります。

32枚合成(4,8枚合成と同じ切り出しに)

32枚合成を横方向2000ピクセルで切り出し

ほんとすみません😅 こりゃ駄目ですね。ボヤボヤもいいところで、完全に微ブレと陽炎の影響、どちらかというと後者の影響が大きそうです。合成量が多いほど、僅かな空気のゆらぎも無視できないという事がわかりました。というのも、合成した画像の1枚1枚は決してブレていないのです 。とにかくわかったことは、

ピクセルシフト撮影は、望遠レンズでは微ブレと陽炎の影響が出やすく実用が難しい

ということですね。

←オリジナル 32枚合成→ 色の違いは撮影時間の違いによるものです。

今回はピクセルシフト撮影の良さを全く出せませんでしたが(汗)、また違う撮影で(標準か広角レンズで)試してみたいと思います。